Colabを学ぼうシリーズも4回目、カリキュラム通りなら終盤に入りました。

今回は上級編『マシンスペックの活用とトラブル対応』を学んでいきます。

前回の中級編はこちら。

それではさっそく始めていきましょう。

【上級編】マシンスペックの活用とトラブル対応

前回は主にGoogleドライブとの連携について学びました。

今回はカリキュラムをパッと見ただけでも専門用語がいっぱいでてきます。

さすが上級。気合いを入れて学びましょう!

AIが設定した目標

目標: 高度なAI処理(画像生成や音声認識など)を行う。

このパートでは「高性能なAI(画像生成や大規模言語モデル)」を動かせるようになるだけでなく、エラーが起きたときに自分で復旧できる力が身につくそうです。

さすがに全てのエラーには対応できないでしょうが、初歩的な部分でも知っておいたほうがいいでしょうから助かりますね。

さっそく解説してもらいます。

1. ランタイムの変更(GPU/TPU)

なぜこれが必要か?

通常の状態(CPU)は、事務処理は得意ですが、AIの計算(画像処理など)は非常に遅いです。

GPUは「AI専用の加速装置」のようなものです。

これをオンにしないと、画像生成に何十分もかかってしまいます。

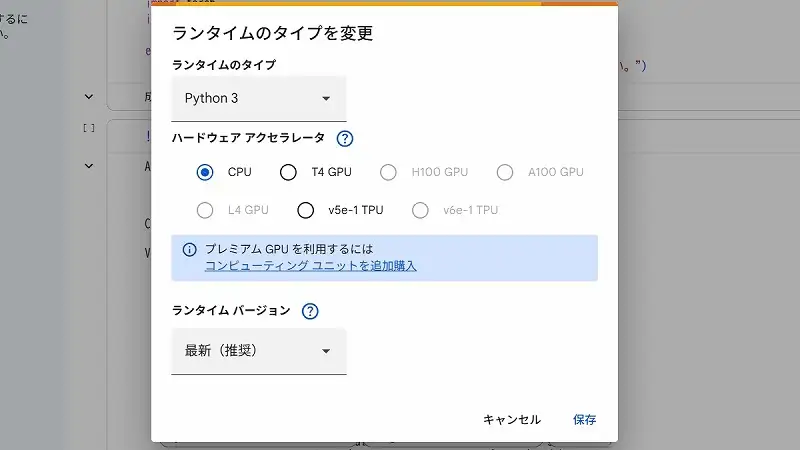

操作手順:

- Colabの上部メニュー「ランタイム」をクリック。

- 「ランタイムのタイプを変更」を選択。

- 「ハードウェア アクセラレータ」の項目で 「T4 GPU」 を選択し、「保存」を押す。

確認ポイント:

右上の接続ステータスが一度「初期化中」になり、再接続されます。

これで加速装置が搭載された状態になりました。

※無料版では使用時間に制限があるため、使い終わったら必ず「接続を解除」するのがマナー(そして制限回避のコツ)です。

2. コマンドライン操作(システムへの直接命令)

なぜこれが必要か?

Pythonコードだけでなく、Colabが動いている裏側のコンピュータ(Linux)に直接命令を出せると、ファイルの場所確認やGPUの状態確認がスムーズになります。

先頭に ! をつけるのがルールです。

試すべきコマンド(コードセルに入力して実行してください):

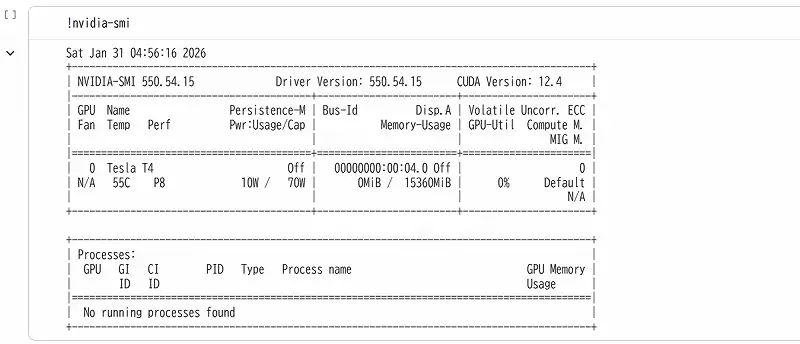

- GPUの健康診断:

!nvidia-smi

解説: これを実行して表のようなものが表示されればGPUが正しく動いています。

右側の「Memory-Usage」を見れば、AIがどれくらいメモリを食っているかがわかります。

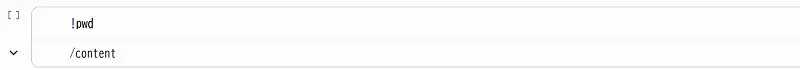

- 今どこにいるか確認:

!pwd

解説: “Print Working Directory”の略です。

通常は /content と表示されます。

- ファイル一覧を見る:

!ls -l

解説: 今いる場所にあるファイルを表示します。

アップロードしたはずの画像が見当たらない時、これで確認します。

3. セッション管理と再起動(トラブルシューティング)

なぜこれが必要か?

AIを動かしていると、「メモリ不足」で固まったり、変数がごちゃごちゃになってエラーが消えなくなったりします。

その時の「直し方」には2段階あります。

レベル1:ランタイムを再起動(ソフトリセット)

- 操作: メニュー「ランタイム」→「セッションを再起動」

- 効果: 変数(x = 10など)やメモリの中身は消えますが、アップロードしたファイルやインストールしたライブラリは残ります。

- 使い所: コードの挙動がおかしい時、とりあえずこれを試します。

レベル2:ランタイムの接続解除と削除(ハードリセット)

- 操作: メニュー「ランタイム」→「ランタイムを接続解除して削除」

- 効果: 全て消えます。 工場出荷状態に戻ります。ファイルも消えるので再アップロードが必要です。

- 使い所: どうやってもエラーが直らない時や、GPUの使用時間をリセットしたい時(完全にゼロにはなりませんが、セッションを切るために使います)。

4. 実践の前に1つずつ解決していこう

AIの解説を要約してきましたが、何を言っているのか正直わからない部分も多かった。

この後に実践課題を提示してもらっているが、1度戻って解決していきます。

GPUの健康診断

まずはGPUの健康診断から。

AIの指示では『!nvidia-smi』を実行し、表のようなものが表示されればGPUが正しく動いている証拠らしい。

早速やってみると・・・

これを実行して表のようなものが表示されればGPUが正しく動いているらしいが、出てきませんね。

最初のランタイムの変更(GPU/TPU)をしていないからでしょうか。

ハードウェアアクセラレータをCPUからT4 GPUに変更して保存し、もう一度プログラムを実行すると、

ちゃんと表が出てきました。これで高性能なAIを使えているということですね。

ではなぜCPUの時はこの表が出てこなかったのでしょう。

AIに聞いてみると、

このコマンドは「NVIDIA製のGPU」が入っている時しか動きません。

nvidia-smi は以下のような意味の略語です。

- NVIDIA: GPUを作っているメーカーの名前

- SMI: System Management Interface(システム管理画面)

つまり、これは「NVIDIA製のGPU専用の管理画面を開け」という命令なのです。

Colabで「CPUモード」を選んでいる時、その裏側にあるコンピュータにはNVIDIA製のGPUが物理的に接続されていません(あるいは認識されていません)。

そのため、コンピュータに「NVIDIAの管理画面を出して」と命令しても、コンピュータは「NVIDIAの製品なんてここにはないから、そんな管理ツールも入ってないよ(command not found)」と返してくるわけです。

NVIDIA製じゃないから表が出なかったってことなんですね。

理解しました。

今どこにいるか確認

『!pwd』 と打つと /content が返ってきました

/content は、一言で言うと「Googleがあなたに貸してくれた、作業専用の机(デスクトップ)」です。

/ (スラッシュ):

これは「ルート(根っこ)」と呼ばれ、コンピュータの一番上の階層を表します。Windowsでいう「Cドライブ」のようなものです。

content:

その中にある「中身」や「内容」という意味のフォルダ名です。

つまり /content は、「コンピュータの一番上にある、contentという名前のフォルダの中にいますよ」という意味です。

書いていることは理解できますが、これをいつどのような場面で使うのでしょうか。

使い道もAIに聞いてみました。

・ファイルのフォルダ移動時に「今、ちゃんと移動できたかな?」と確認するために !pwd を使う。

・Pythonのコードで、「このフォルダにある画像を全部読み込んで」と指示したい時、正確な住所(パス)を書く時に !pwd を打ち、出てきた文字列をコピーしてPythonコードに貼り付けるという時に使います。

このような場面で使うそうです。

ここは説明を聞くより、その時が来たときに見返して覚えるのが早そうですね。

ファイル一覧を見る

『!ls -l』 と打つと、

total 4

drwxr-xr-x 1 root root 4096 Dec 9 14:42 sample_data

と返ってきました。

これもAIにどういう意味なのか聞いてみましょう。

これは、Windowsでいう「フォルダの『詳細表示』モード」と同じ情報が表示されています。

暗号のように見えますが、分解すると「誰が、いつ、どんなファイルを置いたか」が書いてあります。

1行ごとの意味

- total 4

- これは「この場所にあるファイルが合計でどれくらいの容量(ブロック数)を使っているか」を示しています。今はあまり気にしなくて大丈夫です。

- これは「この場所にあるファイルが合計でどれくらいの容量(ブロック数)を使っているか」を示しています。今はあまり気にしなくて大丈夫です。

- drwxr-xr-x 1 root root 4096 Dec 9 14:42 sample_data

これを左から順に解読します。- d (重要)

- 先頭の d は Directory(ディレクトリ)、つまり「これはファイルではなくフォルダですよ」という意味です。

- もしここが – なら、普通のファイル(画像やテキストなど)です。

- rwxr-xr-x

- これは「権限」です。「読み込み(r)・書き込み(w)・実行(x)」の許可証です。「管理者は全部できるけど、他の人は見るだけ」といった設定が書かれています。

- root root

- 持ち主の名前です。Colabのシステム管理者である「root(ルート)」さんが作ったものだということを示しています。

- 4096

- サイズ(バイト)です。フォルダ自体の管理情報のサイズが表示されています。

- Dec 9 14:42

- 最後に更新された日時です(このColabの環境が作られた日時であることが多いです)。

- sample_data

・ファイルまたはフォルダの名前です。

- d (重要)

つまり、どういうこと?

この表示全体で、以下のことを伝えています。

「ここには、『sample_data』という名前のフォルダが1つだけあります。それは12月9日に管理者(root)によって作られたものです」

確かにWindowsのプロパティで出てくる詳細情報のような感じですね。

ただ文字列が初心者から見ると独特なものなので、覚えるまでが大変そうです。

これで一通り解説されたコマンドを使ってみたので実践課題に進みましょう。

5. 実践して覚えよう

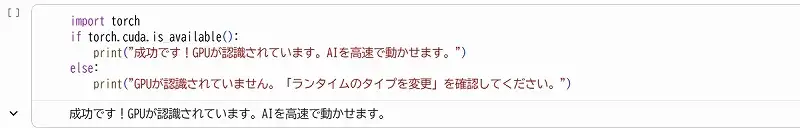

以下のコードをColabのセルにコピペして実行し、GPUが認識されているか確認してみましょう。

# GPUが使えるか確認するコマンド

!nvidia-smi

# 完了したら、Pythonからも確認してみましょう

import torch

if torch.cuda.is_available():

print("成功です!GPUが認識されています。AIを高速で動かせます。")

else:

print("GPUが認識されていません。「ランタイムのタイプを変更」を確認してください。")これができれば、あなたはもう「ただコードをコピペする人」ではなく、「環境を制御できるエンジニア」の入り口に立っています。

実践結果

GPUが使えるか確認するコマンド

はすでに実行済みのため、Pythonから確認だけ行いましょう。

成功です!

と出ましたね。

高度なAI処理が必要な場合はランタイムの変更をする。

しっかりと覚えておきましょう。

まとめ

今回はマシンスペックの活用とトラブル対応について主に勉強しました。

まだ高度なAI処理が必要な場面に出くわしていないので、その力量を確かめることができないのが残念です。

いまはカリキュラムの途中なので、終わってからAIにお願いでもしましょうかね。

次回はいよいよカリキュラムの最後『応用編』です。

気を抜かずに引き続き頑張りましょう。